混合专家架构 关键字列表

AI21 Labs 获得来自 Google 和 Nvidia 的 3 亿美元融资 拓展企业级 AI 产品

以色列 AI 初创公司 AI21 Labs 获得谷歌和英伟达3亿美元的 D 轮融资,进一步推进大型语言模型与企业级人工智能产品研发,总融资额达6.36亿美元。

Meta发布Llama 4,新一代旗舰AI模型

Meta发布了Llama家族的新一代AI模型Llama 4,包括Scout、Maverick和Behemoth三个模型。这些模型在大量未标记的文本、图像和视频数据上进行训练,具备广泛的视觉理解能力。Llama 4采用混合专家架构,提高了计算效率。Meta表示,这标志着Llama生态系统新时代的开始,将为用户带来更强大的AI能力。

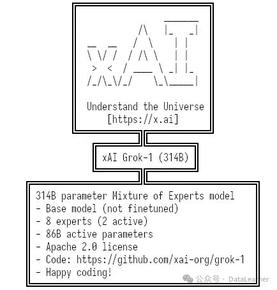

600GB显存才能拉起来的Grok-1不太惊艳!马斯克大模型企业xAI开源Grok-1,截止目前全球参数规模最大的MoE大模型!

马斯克旗下大模型公司开发的Grok-1大语言模型已开源,采用Apache2.0协议。Grok-1是一个混合专家架构模型,参数总数3140亿,每次推理激活860亿。虽然在MMLU和GSM8K评测中表现不错,但与同类模型相比资源消耗大而收益不显著。开源的仅为推理代码,训练基础设施和tokenizer的特殊token作用未透露。