OpenAI提供大模型的提示缓存(Prompt Caching):GPT-4o系列模型输入价格下降一半,访问速度提升80%

Azure OpenAI 的提示缓存功能为处理长提示和重复请求提供了一个非常有价值的优化方案。它通过减少计算延迟和成本,显著提高了模型的效率。

微软发布第四代Phi系列大模型,140亿参数的Phi-4 14B模型数学推理方面评测结果超过GPT 4o,复杂推理能力大幅增强

微软将大语言模型分为两类,参数较小的规模被称为小语言模型(Small Language Models, SLMs)。微软认为,使用高质量的数据集训练小规模参数语言模型,以达成更高的推理能力是很重要的一个方向。为此,微软发布了Phi系列的大语言模型。

Anthropic发布全新的Haiku 3.5和升级版Sonnet 3.5,大模型控制电脑使用能力强了很多!

Anthropic在这次更新中不仅提升了模型的整体性能,还在专业领域如编程、视觉理解等方面取得了显著进步。特别是新增的计算机使用能力,虽然仍处于早期阶段,但展现出了AI与计算机交互的新可能性。

重磅!OpenAI发布最强推理模型“OpenAI o1”(代号草莓),大模型逻辑推理能力大幅提升,官方宣称超越部分人类博士水平!

OpenAI发布了新的大语言模型o1,专注于逻辑推理优化,其推理能力在多个领域超越现有模型。o1模型通过思维链模式训练,提升了数学、编程、科学问题解决能力。在AIME和GPQA测试中表现优异,超越人类专家水平。o1模型使用大规模强化学习算法,强调思维链和强化学习的重要性。OpenAI未向用户展示原始思维链,但提供摘要。o1模型目前可供ChatGPT Plus订阅用户使用。

Mistral AI开源120亿参数的Mistral NeMo,Mistral 7B模型的继任者!免费开源!中文能力大幅增强!

Mistral NeMo这个拥有120亿参数的模型不仅性能卓越,还为AI的普及和应用创新铺平了道路。

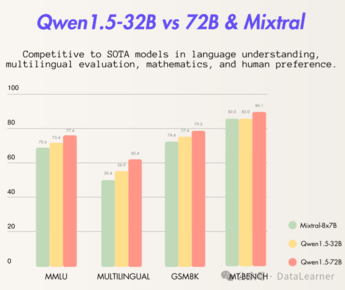

高产的阿里!Qwen1.5系列再次更新:阿里开源320亿参数Qwen1.5-32B,评测超Mixtral MoE,性价比更高!

阿里巴巴开源了320亿参数的大语言模型Qwen1.5-32B,性能略超Mixtral 8×7B MoE,略低于720亿参数的Qwen-1.5-72B。Qwen1.5-32B具有高性价比,显存需求减半,适合更广泛使用。模型在多项评测中表现优秀,特别是在推理和数学方面。支持32K上下文长度,以通义千问的开源协议发布,允许商用。

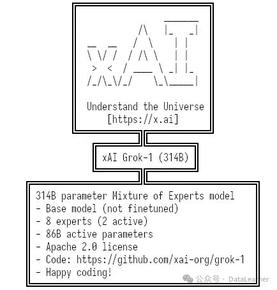

600GB显存才能拉起来的Grok-1不太惊艳!马斯克大模型企业xAI开源Grok-1,截止目前全球参数规模最大的MoE大模型!

马斯克旗下大模型公司开发的Grok-1大语言模型已开源,采用Apache2.0协议。Grok-1是一个混合专家架构模型,参数总数3140亿,每次推理激活860亿。虽然在MMLU和GSM8K评测中表现不错,但与同类模型相比资源消耗大而收益不显著。开源的仅为推理代码,训练基础设施和tokenizer的特殊token作用未透露。

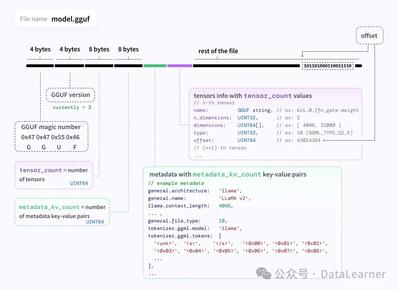

GGUF格式文件可能是未来大模型文件标准格式之一!HuggingFace宣布对GGUF增加更多的支持,可以直接查看大模型元数据!

HuggingFace宣布将加大对GGUF格式的大模型文件的支持。GGUF(GPT-Generated Unified Format)是一种高效存储和交换大模型预训练结果的二进制格式,由llama.cpp创始人Georgi Gerganov定义。HuggingFace的支持包括模型检索过滤、预览GGUF元数据和提供工具支持网站显示平台GGUF格式模型信息。这显示了开源社区对大模型的重要贡献和国外开源生态的互相融合。

程序员职业危机!全球首个AI软件工程师问世:CognitionAI发布可以自己训练微调大模型的AI软件工程师Devin

当前的GPT-4等模型已经在代码补全和生成方面为程序员节省了大量的时间。但是,大多数编程领域的大模型应用都是单行代码补全或者单个函数生成的方式。

难得一见,OpenAI开源大模型调测工具Transformer Debugger:可以在训练大模型之前理解模型的运行情况并干预

OpenAI开源了Transformer Debugger,这是一个可视化工具,用于帮助开发者调测和理解大型语言模型的推理过程。工具通过可视化展示模型的神经元、注意力机制和自编码器的激活情况,提供对模型行为的解释。Transformer Debugger包括神经元观察器、激活服务器、模型库和汇总激活数据集等组件。

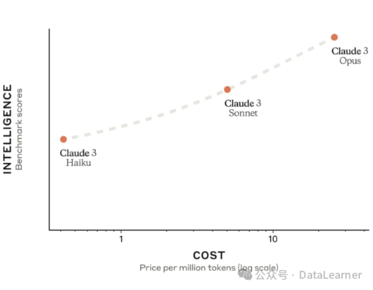

评测结果超过GPT-4,Anthropic发布第三代大语言模型Claude3,具有多模态能力,实际评测表现优秀!但幻觉问题不小!

Anthropic推出了第三代大语言模型Claude3,包含三个版本:Claude3-Opus、Claude3-Sonnet和Claude3-Haiku,能力和成本递减。Claude3-Opus在多项评测中超过GPT-4,支持多模态和最高100万上下文输入。